File Robots.txt là gì? Cách tạo file robots.txt chuẩn SEO

Bạn có từng nghĩ cách để để một con robot trong công cụ tìm kiếm phân tích dữ liệu website để index thế nào? Làm sao để trang web của bạn có thể index nhanh hơn? Những điều này để thực hiện được cần có một file Robots.txt. Vậy Robots.txt là gì? File này dùng để làm gì? Cách thức nó hoạt động thế nào? Bài viết sau đây sẽ giúp bạn giải đáp những câu hỏi trên.

File Robots.txt là gì?

File Robots.txt là một tập tin văn bản có dạng .txt đơn giản. Nó là một phần của Robot Exclusion Protocol (REP) chứa nhóm các tiêu chuẩn website quy định cách robot web thu thập dữ liệu trên web, index nội dung, truy cập và cung cấp nội dung đó cho người dùng. Nó sẽ giúp nhà quản trị web có thể chủ động và linh hoạt hơn trong việc cho phép hay không cho phép con bot của Google index nội dung trong trang của mình.

Có thể hiểu đơn giản, File Robots.txt là tập tin chứa đuôi .txt chứa những tiêu chuẩn web do quản trị viên lập ra để hướng dẫn những công cụ tìm kiếm thu thập thông tin trên web của mình để lập chỉ mục. Nếu website thiếu File Robots.txt thì các bot tìm kiếm sẽ truy cập được tất cả các mục trong trang. Trong một số trường hợp điều này có khả năng ảnh hưởng xấu đến SEO cũng như chất lượng website.

- Xem thêm: Sitemap là gì?

File robots.txt dùng để làm gì?

Điểm mạnh

Tệp Robots.txt có những công dụng như sau:

- Chặn công cụ tìm kiếm trong trường hợp website chưa hoàn thiện

Nếu đang trong quá trình tạo lập, dùng thử website, bạn cần sẽ cần thời gian để hoàn thiện nó. Do đó, bạn sẽ không muốn các trình duyệt truy cập và index website lúc này. Robots.txt sẽ có nhiệm vụ chặn truy cập và index website từ những công cụ tìm kiếm. Bởi nếu không có tệp Robots.txt thì sẽ gây ảnh hưởng đến giá trị website và không có lợi cho SEO.

- Chăn trang tìm kiếm các kết quả xấu

Thông thường, Google sẽ đánh giá các URL có lợi. Do đó, để hạn chế các URL không chuẩn thì bạn cần thiết lập những tiêu chuẩn cho quá trình tìm kiếm website.

- Chặn công cụ thu thập liên kết website

Các công cụ như Ahref, Organic keyword,… thường sẽ cho phép thu thập dữ liệu trang thông qua địa chỉ website. Điều này sẽ giúp đối thủ dễ dàng đọc thông tin phân tích web của bạn để bắt chước và cạnh tranh với các từ khóa top của bạn. Nếu muốn hạn chế điều này thì cần có file Robots.txt.

Điểm yếu

Tuy nhiên, file Robots.txt sẽ có một số hạn chế như sau:

- Không phải mọi trình duyệt tìm kiếm đều hỗ trợ các lệnh trong tệp Robots.txt. Bởi một số trình thu thập dữ liệu sẽ có quyền không tuân theo tệp. Vì thế, để bảo mật tệp tốt nhất thì bạn nên đặt mật khẩu cho máy tệp đó.

- Mỗi trình duyệt sẽ tuân theo những quy chuẩn của lệnh trong tệp Robots.txt nhưng cách giải trình dữ liệu lại khác nhau. Một số trình sẽ không hiểu được câu lệnh trong tệp. Vì thế, người quản trị web cần nắm rõ cú pháp đảm bảo thích hợp với từng công cụ thu thập dữ liệu.

- Trong một số trường hợp, nếu đã chặn URL hoặc file trên web nhưng những URL hay file đó vẫn xuất hiện trên trang khác thì Google vẫn đọc được và lập chỉ mục cho URL đó. Điều này sẽ khiến nội dung trong các file này xuất hiện trên trang tìm kiếm của Google. Vì thế nếu URL đó không quá cần thiết bị hãy xóa nó đi.

File Robots.txt hoạt động như thế nào

File Robots.txt có cách thức hoạt động như sau:

- B1: Crawl (cào/phân tích) dữ liệu website để khám phá nội dung. Để thực hiện được thì các công cụ sẽ theo các liên kết đến mọi trang rồi thu thập dữ liệu của hàng tỷ trang khác nhau. Quá trình này còn được gọi là spidering.

- B2: index nội dung để đảm bảo yêu cầu tìm kiếm của người dùng. Lúc này, file Robots.txt sẽ chứa những thông tin về các công cụ Google thu thập dữ liệu. Tại đây, con bot sẽ được hướng dẫn thêm các thông tin cho quá trình này. Nếu tệp Robots.txt không chứa chỉ thị nào cho các user-agent hoặc quản trị viên không tạo Robots.txt cho website thì con bot sẽ thu thập mọi thông tin trên khác trên web đó.

Tìm hiểu thêm: Các bước tạo Silo cho website hiện nay

Cách tạo và kiểm tra xem File Robots.txt hoạt động hay chưa

Người dùng có thể tự tạo file Robots.txt bằng notepad rất đơn giản. Nếu bạn dùng wordpress thì file Robots.txt sẽ có dạng như sau:

User-agent: *

Disallow: /wp-

Disallow: /feed/

Disallow: /trackback/

Ví dụ:

- User-agent: * : Cho tất cả các loại bot truy cập vào website

- Disallow: / : Chặn không cho bot truy cập vào toàn bộ website

- Disallow: /images/abc.JPG : Chặn không cho bot truy cập vào file ảnh có tên abc.JPG

- Disallow: /administrator/ : chặn không cho bot truy cập vào trang quản trị.

Bạn có thể tham khảo 3 cách tạo Robots.txt dưới đây:

Cách 1: dùng Yoast SEO

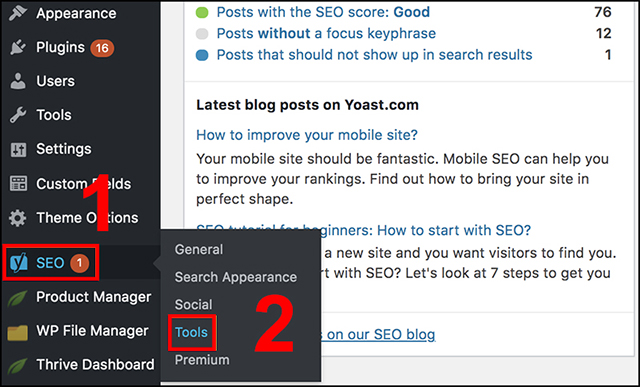

B1: đăng nhập vào website trên wordpress, giao diện trang wordpress Dashboard sẽ hiện lên.

B2: chọn SEO > tools

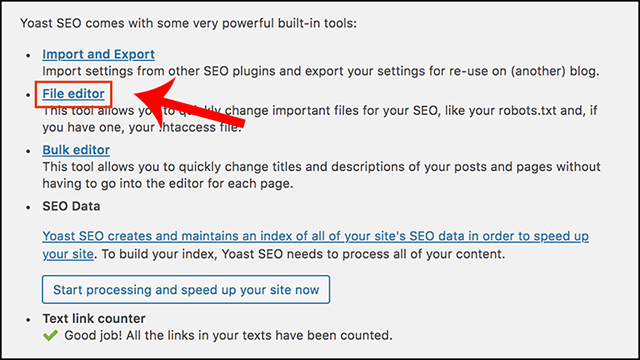

B3: chọn file editor

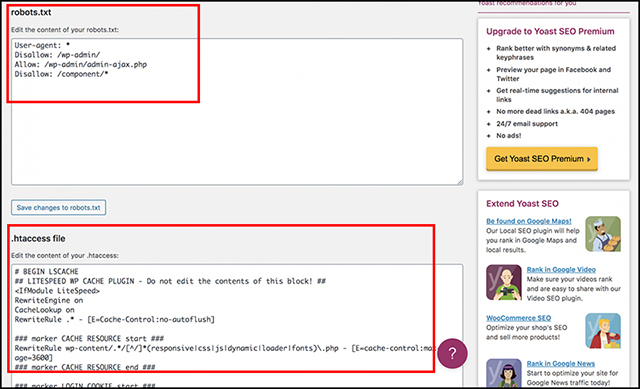

Lúc này mục Robots.txt và .htaccess sẽ hiện lên để bạn tạo file.

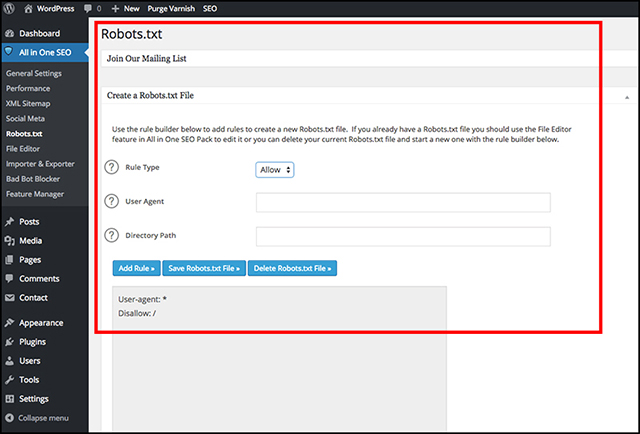

Cách 2: dùng Plugin all in one SEO

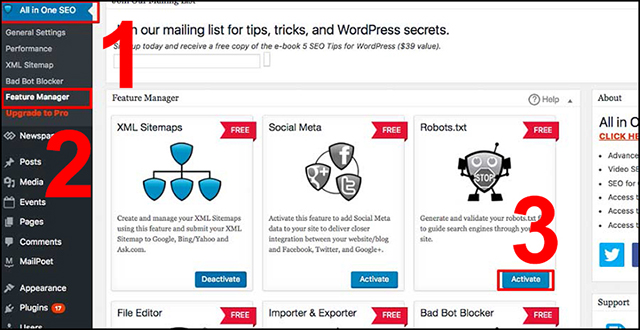

B1: truy cập vào Plugin all in one SEP pack.

B2: chọn all in one SEO > feature manager > chọn activate tại mục Robots.txt

B3: tạo và chỉnh file Robots.txt

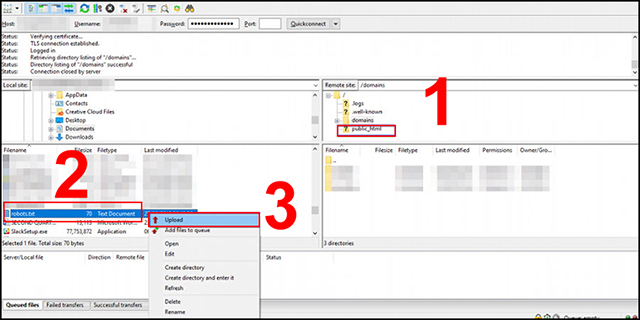

Cách 3: tạo và upload file Robots.txt qua FTP

B1: mở notepad để tạo mẫu file.

B2: mở FTP > chọn mục public_html > chọn Robots.txt > upload

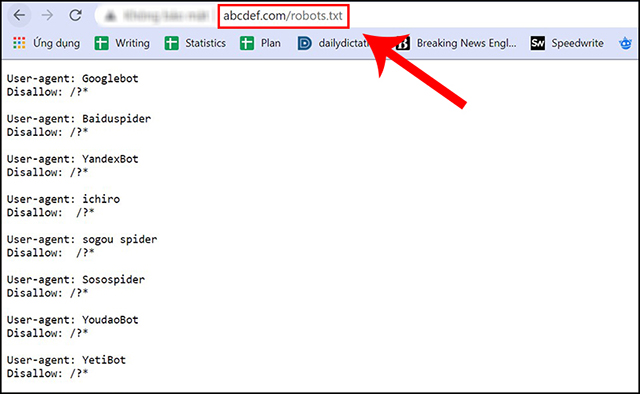

Để kiểm tra một website có Robots.txt không thì bạn có thể làm như sau:

- Nhập Root Domain > chèn /robots.txt vào cuối > chọn enter

Lưu ý: nếu không có trang .txt xuất hiện trang web đó không có file Robots.txt.

Cách làm cho File Robots.txt hoạt động tối ưu với SEO

Hiện có rất nhiều trang blog dùng tệp Robots.txt đơn giản. Nội dung chúng sẽ khác nhau tùy theo nhu cầu từng trang web. Cụ thể:

User-agent: *

Disallow:

Sitemap: http://www.example.com/post-sitemap.xml

Tệp này sẽ cho phép tất cả bot lập chỉ mục mọi nội dung và cung cấp liên kết sơ bộ đến trang web XML. Với các trang wordpress thì bạn nên sử dụng quy tắc sau:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: http://www.example.com/post-sitemap.xml

Điều này sẽ giúp các bot tìm kiếm lập chỉ mục mộ hình ảnh và tệp wordpress. Nó sẽ không cho bot tìm kiếm lập chỉ mục tệp plugin, khu quản trị, tệp readme và link liên kết. Khi thêm sơ đồ trang web vào tệp Robots.txt bạn sẽ cho các bot Google thấy được mọi nội dung trên trang web của bạn.

Tham khảo thêm: Google Fred có ảnh hưởng đến những website nào?

Đồng thời bạn cần nhớ một số quy tắc sau:

- Đảm bảo các nội dung hay phần mục trên trang web của bạn không bị chặn.

- Liên kết trên các trang bị Robots.txt chặn sẽ không được theo dõi.

- Không dùng Robots.txt để chặn dữ liệu nhạy cảm xuất hiện trong kết quả SERP.

- Một số công cụ tìm kiếm sẽ có nhiều tác nhân người dùng.

- Công cụ tìm kiếm sẽ lưu trữ nội dung Robots.txt và thường update nội dung được lưu trong bộ nhớ cache tối thiểu 1 lần/ngày.

Trên đây là các thông tin về tệp Robots.txt chi tiết nhất. Hy vọng thông tin trong bài sẽ hữu ích với bạn.

Write a Comment